شرکت آنتروپیک بهتازگی اعلام کرده موفق به شناسایی و خنثیسازی یک حمله سایبری بیسابقه شده است که تقریبا بهطور کامل توسط ایجنتهای هوش مصنوعی هدایت شده است. ظاهرا یک گروه هکری وابسته به دولت چین، تواسنته با جیلبریک (Jailbreak) هوش مصنوعی کلاود (Claude) آن را فریب دهد تا بهجای فعالیتهای دفاعی وارد یک عملیات تهاجمی چند مرحلهای شود. درواقع، از ایجنتهای هوش مصنوعی جهت شناسایی آسیبپذیری و نوشتن کدهای اکسپلویت برای ۳۰ سازمان بینالمللی استفاده شده است و تعداد انگشتشماری از اهداف شامل شرکتهای بزرگ فناوری، نهادهای مالی و حتی بخشهایی از دولتها مورد نفوذ قرار گرفتهاند.

نکته تکاندهنده ماجرا اینجاست که ۸۰ تا ۹۰٪ کار توسط هوش مصنوعی انجام شده است و اپراتورهای انسانی فقط برای چند تصمیم حساس وارد عملیات شدهاند. اجرای حملات سایبری تهاجمی معمولا به تیمهای متخصص، هزینههای بالا و زمان طولانی نیاز دارد و هر تیم فقط میتواند تعداد محدودی حمله را بهطور همزمان مدیریت کند. بهعلاوه، بهمرور زمان هرچه هوش مصنوعی پیشرفتهتر شود، تعداد، سرعت و پیچیدگی این حملات نیز بیشتر خواهد شد. اکنون سوال این است که آیا باید واقعا نگران حملات سایبری با هوش مصنوعی باشیم؟ اگر اینطور باشد، قدم بعدی ما چیست؟ در این مطلب از میهن بلاکچین ضمن بررسی جزئیات این حمله، سعی میکنیم پاسخ این سوالات را هم بیابیم.

بررسی نخستین حمله سایبری با هوش مصنوعی

تصور کنید یک تیم هکری، به جای ماهها کار مداوم شبانهروزی، از گروهی از «دستیاران دیجیتال خستگیناپذیر» کمک بگیرد که میتوانند ساعتها بدون توقف کار کنند، مرحلهبهمرحله تصمیم بگیرند و هر بار براساس بازخوردی که میگیرند، روش خود را اصلاح کنند. این همان اتفاقی است که در حمله اخیر رخ داد؛ هکرهای چینی برای نفوذ به ۳۰ شرکت جهانی با استفاده از هوش مصنوعی کلاود متعلق به شرکت آنتروپیک یک حمله سایبری ایجنتمحور انجام دادند.

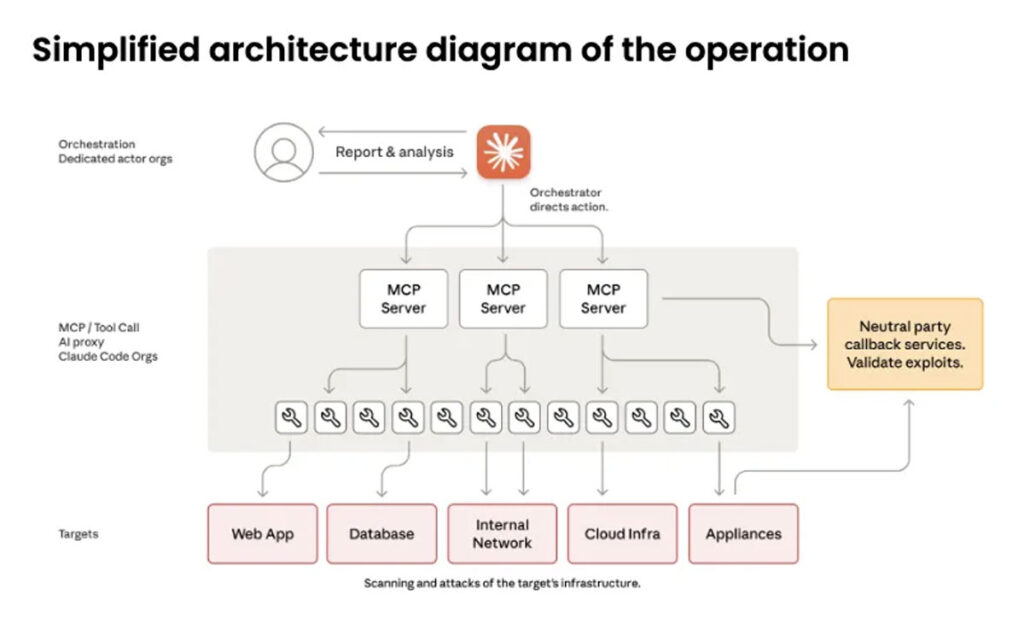

در دنیای فناوری، هوش مصنوعی ایجنتمحور (Agentic AI) به سیستمهایی گفته میشود که میتوانند بهصورت خودمختار و طولانیمدت کار کنند، خودشان تصمیمهای تاکتیکی بگیرند و آنها را در چارچوب اهداف استراتژیک اجرا کنند. در این حمله، هکرهای وابسته به دولت چین از دستیار کدنویسی کلاود (Claude Code) استفاده کردند که یک نسخه ایجنتمحور از هوش مصنوعی کلاود است و میتواند به ابزارهای خارجی متصل شود، اطلاعات و زمینه کار را در جلسات مختلف حفظ کند و براساس بازخورد کاربر، عملکرد خود را اصلاح کند.

دستیار کدنویسی کلاود یک اپلیکیشن کامپیوتری عمومی و قابلدسترس است که معمولاً برنامهنویسان از آن برای توسعه نرمافزار استفاده میکنند. مهاجمان با آمادهسازی ابزارهای جانبی و هماهنگیهای دقیق، قابلیتهای کلاود کد را برای انجام یک عملیات تهاجمی بازطراحی کردند. آنها عملیات بزرگ خود را به مراحل بسیار کوچکتری تقسیم کردند تا ناوگانی از ایجنتهای هوش مصنوعی بتوانند هر گام را جداگانه اجرا کنند و از فعال شدن سیستم دفاعی آنتروپیک جلوگیری شود.

برخلاف تصور رایج، اصطلاح «حمله سایبری» همیشه به معنای تخریب گسترده نیست. بسیاری از حملات، مانند همین مورد، با هدف جاسوسی انجام میشوند. وارد کردن آسیب آشکار و قابلتشخیص تنها باعث لو رفتن حمله میشود. به همین دلیل، کشورها سرمایهگذاری عظیمی روی برنامههای جاسوسی سایبری میکنند.

در این حمله جاسوسی، هکرهای انسانی ابتدا فهرستی از اهداف را تهیه و سپس یک چارچوب مبتنی بر هوش مصنوعی را راهاندازی کردند تا بتوانند چندین عملیات شناسایی را بهصورت همزمان روی اهداف مختلف اجرا کنند. میتوانید اینطور تصور کنید که هکرهای انسانی مانند مدیرانی بودند که تیمی از «نوچههای دیجیتال» را مدیریت میکردند. آنها اهداف را برای دستیاران خود مشخص میکردند و فقط تایید مراحل مهم را برعهده داشتند؛ درمقابل کار طاقتفرسای هزاران تلاش برای ورود یا تحلیل حجم عظیمی از دادههای سرقتشده برعهده دستیاران دیجیتال بود.

در نقاط حساس فرآیند، اپراتورهای انسانی نتایج را بررسی و اجازه عبور به مرحله بعد را صادر میکردند. سپس، ایجنتهای کلاود بهطور مستقل با استفاده از کدهای مخرب وارد سیستم میشدند، اطلاعات کاربری و رمزهای عبور را جمعآوری میکردند، اعتبارنامههای سرقتشده را روی سیستمهای دیگر امتحان میکردند و در شبکه داخلی حرکات جانبی انجام میدادند. این ایجنتها در مرحله جمعآوری داده، پایگاههای داده و سیستمهای داخلی را جستوجو میکردند، اطلاعات را استخراج و ارزش اطلاعاتی آنها را تحلیل کرده و سپس یافتهها را بر اساس حساسیت دستهبندی میکردند. هر ایجنت نیز میتوانست چندین روز بدون از دست دادن زمینه و هدف، کار خودش را ادامه دهد.

براساس گزارش آنتروپیک، ۸۰ تا ۹۰٪ عملیات تاکتیکی بهطور مستقل و بدون نیاز به نظارت یا اصلاح انسانی انجام شده است. در این عملیات نقش انسان از یک «هکر فعال» به «ناظر استراتژیک» تبدیل شده است که فقط برای تصمیمگیریهای مهم مداخله کرده است.

البته باید توجه داشت که این حمله کاملاً بدون انسان انجام نشده است؛ زیرا تمام مراحل این زنجیره، ارزش یا دشواری یکسانی ندارند. برخی از آنها گلوگاههای مهمتری هستند و همچنان به تخصص انسانی نیاز دارند. نکته مهم همین است که هوش مصنوعی هنوز توان انجام حمله از ابتدا تا انتها را ندارد و طرح کلی و تصمیمهای استراتژيک از طریق هکرهای انسانی ارائه شده است.

بهطور مثال، کشف خودکار سرویسهای داخلی یا نقشهبرداری از شبکه، کار جدیدی نیست و ابزارهای سنتی هم میتوانند آن را انجام دهند. درمقابل، توانایی هوش مصنوعی برای آزمودن خودکار احراز هویت و روشهای ورود اهمیت بیشتری دارد؛ زیرا ابزارهای موجود در این بخش ضعیفتر هستند. بااینحال، مهمترین بخش این حمله احتمالاً توان ایجنتهای کلاود در تحلیل حجم عظیم دادههای سرقتشده و تشخیص اطلاعات مهم بوده است. این قابلیت بار انسانی عملیات حمله را بهطور قابلتوجهی کاهش میدهد و نسبت «هزینه-فایده» را به شکل چشمگیری برای مهاجمان بهبود میدهد.

قابلیتهای سایبری هوش مصنوعی در آینده

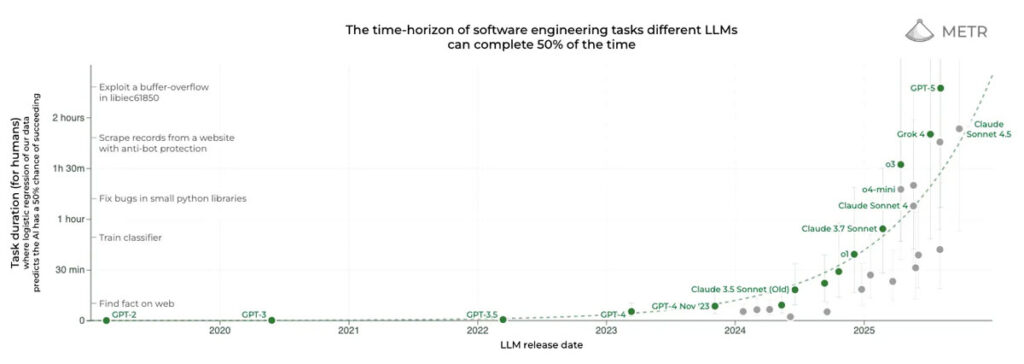

بر اساس گزارش آتروپیک، هوش مصنوعی کلود توانسته مراحل مختلف یک حمله شامل شناسایی و نفوذ را در بازههای ۱ تا ۴ ساعته انجام دهد. اگرچه نرخ موفقیت پایین و محدود بوده است، اما همین «انگشتشمار» اهمیت زیادی دارد؛ زیرا هکرها فقط باید چند بار موفق شوند تا تا نتایج ارزشمندی بهدست آورند. نکته مهم این است که سطح خودکار شدن این حملات نسبت به نمونههای مشابه چند ماه قبل که نقش انسان بسیار پررنگتر بود، یک جهش محسوب میشود.

مطالعات شرکت مستقل “METR” که نرخ پیشرفت مدلهای هوش مصنوعی را رصد میکند، نشان میدهد که توان عملیاتی AI با سرعتی سریع و نسبتاً قابل پیشبینی در حال افزایش است. آنها دریافتهاند که مدلهای فعلی مانند GPT-5 و Claude 4.5 Sonnet میتوانند وظایف نرمافزاری پیچیده را در حدود دو ساعت با موفقیت حدود ۵۰٪ انجام دهند که دقیقاً با مشاهدات آنتروپیک در مورد حمله سایبری خودکار در دنیای واقعی همخوانی دارد.

چنین روندی نگرانکننده است، زیرا دادههای این شرکت نشان میدهد که توان مدلهای هوش مصنوعی از سال ۲۰۲۴ تقریباً هر ۱۱۸ تا ۲۱۲ روز دو برابر شده است. اگر این سرعت ادامه داشته باشد، مدلها تا اوایل ۲۰۲۶ میتوانند زمان کل عملیات را به ۴ ساعت برسانند. این یعنی هوش مصنوعی میتواند حملات چندمرحلهای پیچیدهتری را انجام دهد، توانایی بیشتری برای دورزدن دفاعها دارد و وابستگی کمتری به نظارت انسانی خواهد داشت.

اما تنها قدرت مدلها مهم نیست؛ نوآوری در اِسکَفولدینگ (Scaffolding) نیز اهمیت حیاتی دارد. اسکفولدینگ همان چارچوبی است که ابزارهای مورد نیاز برای حمله از نرمافزار کرک پسورد گرفته تا تکنیکهای چندمرحلهای برای استدلال بهتر و یکپارچهسازی با ابزارهای خارجی را در اختیار ناوگان ایجنتهای جاسوس هوش مصنوعی قرار میدهد.

بهطور مثال، مدل جیپیتی فایو (GPT-5) در تستهای سایبری داخلی شرکت اوپن ایآی (OpenAI) عملکرد چشمگیری نداشت، اما شرکت “XBOW” نشان داد که همین مدل با اسکفولدینگ اختصاصی میتواند دو برابر بهتر عمل کند. این یعنی اگر مدل و اسکفولدینگ بهطور همزمان بهبود یابند، توان تهاجمی بسیار سریعتر از انتظار افزایش پیدا میکند.

در حمله اخیر یک گلوگاه مهم وجود داشت؛ مهاجمان مجبور بودند ارتباط سهجانبهای را بین خودشان، زیرساخت قربانی و API کلاود حفظ کنند. نکته جالبتر این است هکرهای چینی بهجای استفاده از مدلهای هوش مصنوعی بومی مانند Qwen ،Kimi یا دیپسیک (DeepSeek) از مدل کلاود استفاده کردند. این موضوع نشان میدهد که مدلهای داخلی چین هنوز به سطح لازم برای خودکاریسازی حملات سایبری نرسیدهاند و این شکاف کوچک در کوتاه مدت یک مزیت راهبردی و حتی فرصت سیاستگذاری برای غرب ایجاد میکند.

این عقبماندگی از آن جهت یک مزیت بهشمار میآید که برای غرب قدرت «رصد و قطع ارتباط» ایجاد میکند. تا زمانیکه مهاجمان به زیرساخت و APIهای غربی وابسته باشند، عملیات آنها ردپا دارد و قابل شناسایی و خنثیسازی است؛ دقیقا همان کاری که آنتروپیک انجام داد. این وابستگی باعث ایجاد نقاط خفگی یا چوکپوینت (Chokepoints) میشود؛ نقاطی که اگر مدلها روی زیرساختهای بومی چین اجرا میشدند، دیگر وجود نداشتند و قابل ردیابی نبودند.

البته این مزیت موقتی است؛ زیرا مدلهای چینی فقط حدود ۶ تا ۱۲ ماه از غرب عقبتر هستند. بهمحض اینکه یک مدل چینی به اندازه کافی توانمند شود، مهاجمان میتوانند مدلها را دانلود و مستقیما روی زیرساختهای آسیبدیده مستقر کرده و کاملاً مستقل عمل میکنند؛ بدون اینکه به API خارجی نیاز داشته باشند. چنین اتفاقی میتواند زمین بازی را کاملاً تغییر دهد.

آیا هوش مصنوعی تهدیدی برای آینده امنیت سایبری است؟

اهمیت این حمله در مقیاسپذیری بسیار بالایی است که هوش مصنوعی ایجاد کرده است. آنچه مهاجمان انجام دادهاند از نظر فنی چندان «پیشرفته» نیست؛ اما توانستهاند همان کارهای ساده را در حجم بسیار بیشتر و با سرعت خیلی بالاتر انجام دهند. همین موضوع خودش یک خطر بزرگ است؛ زیرا اگر مهاجم بتواند سناریوهای نفوذ را دهها برابر بیشتر و سریعتر امتحان کند، حتی برای سیستمهایی که از امنیت بالاتری برخوردار هستند، احتمال شکست وجود دارد.

نکته مهم این است که هوش مصنوعی محدودیتهای انسانی را از بین برده است. در حالت عادی، دولتها یا گروههای هکری به تعداد محدودی نیروی متخصص وابسته هستند. اما ایجنتهای هوش مصنوعی میتوانند کارهای تاکتیکی یک حمله را بدون توقف و بهصورت مستقل انجام دهند و این یعنی سرعت حملات، تعداد اهداف و حجم عملیات بهصورت بیسابقهای افزایش پیدا میکند.

علاوهبر این، هوش مصنوعی میتواند مرحله «ارزشگذاری اطلاعات» را هم بهصورت خودکار انجام دهد. بهطور مثال، در حمله اخیر ایجنتهای کلاود اطلاعات سرقتشده را دستهبندی و تحلیل کردند تا مشخص شود کدام دادهها ارزشمندتر هستند. با وجود چنین اتوماسیونی مهاجم میتواند در مدت زمان کمتر، حجم بیشتری از اطلاعات مفید را استخراج کند و هزینه و زمان لازم برای تحلیل داده را کاهش دهد.

نکته مهمتر این است که سطح مهارت مورد نیاز برای اجرای حمله هم کاهش پیدا میکند. درحالحاضر، برای اجرای یک عملیات سایبری پیشرفته باید یک تیم باتجربه داشت؛ درحالیکه با وجود ابزارهای خودکار و مدلهای هوش مصنوعی، حتی بازیگران کمتجربهتر هم میتوانند عملیات سایبری را با سرعت و در مقیاسهای گسترده انجام دهند. اگر هزینه و سطح پیچیدگی کاهش پیدا کند، احتمالا در آینده شاهد حملات بیشتری از سوی بازیگران غیردولتی مانند باندهای تبهکار یا حتی افراد عادی ناراضی خواهیم بود.

همچنین، سرعت حملات هم بهطور چشمگیری افزایش پیدا میکند؛ زیرا عملیات با «سرعت هوش مصنوعی» انجام میشود، نه «سرعت انسان». در چنین شرایطی حملات تهاجمی بسیار قویتر میشود؛ زیرا مهاجم میتواند همزمان تعداد بیشتری هدف را نشانه بگیرد و با سرعت بالایی به آنها حمله کند، درمقابل فرصت واکنش مدافعان کاهش مییابد.

آیا خود هوش مصنوعی میتواند این شکاف را پر کند؟

آنتروپیک معتقد است همان قابلیتهایی که باعث قدرت مهاجمان شده است، میتواند به مدافعان هم قدرت ببخشد. اگر کلاود میتواند شناسایی آسیبپذیریهای، نوشتن کدهای مخرب و نفوذ را بهطور خودکار انجام دهد، پس چرا مدافعان نتوانند از مدلهای مشابه برای پیدا کردن نقاط ضعف و نظارت بر تهدیدهای موجود استفاده کنند؟

این استدلال واقعاً درست است؛ هوش مصنوعی دفاعی (Defensive AI) تا همین امروز هم نتایج خوبی داشته است. سیستمهای شکارِ تهدید مبتنی بر هوش مصنوعی خطاهایی را پیدا میکنند که انسانها آنها را نمیبینند. اسکنرهای خودکار، نقاط آسیبپذیر را قبل از مهاجمان شناسایی میکنند و هوش مصنوعی روند تست و انتشار وصلههای امنیتی را سریعتر از گذشته انجام میدهد. پس مشکل این نیست که هوش مصنوعی دفاعی جواب نمیدهد، مسئله اصلی این است که آیا سازمانها آن را بهموقع به کار میگیرند یا نه.

هوش مصنوعی دفاعی در بلندمدت مزایای مهمی را به ارمغان میآورد. سیستمهای دفاعی میتوانند دقیقاً متناسب با نیازهای یک سازمان طراحی شوند، با زیرساخت درونی یکپارچه شوند و حتی همزمان از هزاران سازمان محافظت کنند. ممکن است در آینده هوش مصنوعی دفاعی بتواند نرمافزارهای امن قابلاثبات تولید کند که امروز فاصله زیادی با آنها داریم. بااینوجود، اذعان به مزیتهای بلندمدت هوش مصنوعی دفاعی به معنای امنیت امروز نیست. ما در دورهای هستیم که کفه ترازوی حمله سنگینتر است.

چالش اصلی اینجاست که مدافعان با موانعی روبرو هستند که مهاجمان با آنها سروکار ندارند. بسیاری از سازمانها حتی دستورالعملهای ساده امنیتی فعلی را اجرا نکردهاند، چه برسد به دفاع سایبری مدرن مبتنی بر هوش مصنوعی. بهعلاوه، سازمانها نمیتوانند بهسادگی کل پشته فناوری خود را یکشبه تغییر دهند؛ زیرا زیرساختهای حیاتی آنها اغلب روی سیستمهای قدیمی و چند دهسالهای کار میکند که امکان ادغام فناوریهای جدید در آنها وجود ندارد. درمقابل، مهاجمان میتوانند با بهکارگیری یک مدل جدید، در لحظه توان رزمی خود را بدون نیاز به تغییر زیرساخت، افزایش دهند.

علاوه بر آن، پیادهسازی هوش مصنوعی دفاعی کار سادهای نیست. هر سیستمی که اجازه دسترسی گسترده به شبکه داخلی داشته باشد، اگر دچار خطا یا نفوذ شود، خودش به یک تهدید بزرگ تبدیل میشود. بنابراین تیمهای دفاعی نمیتوانند «سریع و بیپروا» اقدام کنند.

مسئله مهمتر این است که مدافع باید همه مسیرهای نفوذ را ببندد؛ اما مهاجم فقط باید یک نقطه ورود کارآمد پیدا کند. یک ایجنت هوش مصنوعی که بتواند هزاران بردار حمله را در ساعت آزمایش کند، حتی با نرخ موفقیت پایین هم خطرناک است. در مقابل، هوش مصنوعی دفاعی باید در همه نقاط شبکه بدون خطا کار کند و ایجاد این سطح از دقت بسیار سخت و پرهزینه است.

مسئله بعدی عدم تقارن قابلیت اطمینان است. اگرچه نرخ هک موفق کلاود در آزمایشها پایین بوده، اما همین درصد اندک برای مهاجم کافی است. شکست برای مهاجم هزینهای ندارد؛ اما حتی یک نفوذ هم برای آنها ارزش ایجاد میکند. مسئله این است که سیستمهای دفاعی نمیتوانند مدلهای هوش مصنوعی با قابلیت اطمینان پایین را مستقر کنند؛ زیرا ممکن است در دفاع شکست بخورد یا حتی به زیرساختهای حیاتی خودِ سازمان آسیب بزند. به همین دلیل، مهاجم میتواند همان هوش مصنوعی ضعیف را برای حمله امتحان کند، اما برای دفاع تقریباً بلااستفاده است.

این مشکل برای زیرساختهای حیاتی که اولویت آنها تداوم خدمات است، دوچندان میشود. اپراتورها نمیتوانند مدلهایی را که هنوز پایدار نیستند مستقر کنند، زیرا کوچکترین اختلال میتواند سرویس حیاتی یک کشور را از کار بیندازد. گزارشها نشان میدهد بیش از ۷۰٪ از سیستمهای آبی که توسط آژانس حفاظت محیط زیست آمریکا بررسی شده، دارای مشکلات پیشپا افتادهای مانند استفاده از رمزهای عبور ساده، حسابهای مشترک بین همه کارکنان و عدم لغو دسترسی کارمندان سابق بودهاند. از سال ۲۰۱۰ تاکنون بیش از ۱۶۱۰ توصیه امنیتی برای این بخش صادر شده که ۵۶۷ مورد آنها هنوز اجرا نشده است.

بخشی از این مشکل ناشی از عمر زیاد تجهیزات، دشوار بودن بهروزرسانی بدون توقف کامل سیستم و کمبود متخصصان امنیتی است. علاوهبراین، بسیاری از سازمانها توان پرداخت حقوق شرکتهای تکنولوژی را ندارند و نهادهای دولتی هم ارادهای برای کمک ندارند. حتی زمانی که نهادهای فدرال برای کمک وارد عمل میشوند، هماهنگی لازم میان خودشان یا با صنایعی که باید از آنها محافظت کنند وجود ندارد و همین مسئله شکافهای امنیتی را عمیقتر میکند.

درمقابل، مهاجمان با چنین محدودیتهایی روبرو نیستند، اگر ایجنتهای آنها از کار بیفتد یا شناسایی شود، کافی است روش دیگری را امتحان کنند و حمله را از مسیر جدیدی ادامه دهند.

جمعبندی

حمله سایبری که توسط هوش مصنوعی کلاود انجام شد، اثر فوری محدودی داشت و تنها تعداد انگشتشماری از اهداف مورد نفوذ قرار گرفتند. آنتروپیک بهسرعت سیستمهای شناسایی بهتری را پیادهسازی کرد و سازمانهای هدف نیز سیستمهای امنیتی خود را تقویت کردند. اگرچه این اقدامات مانع حملات بعدی نمیشوند، اما سطح دشواری را افزایش میدهند. به هر حال، جهان سایبری سالها با عملیات پیچیده تحت حمایت بازیگران دولتی مواجه بوده است.

آنچه قابلتوجه است، نکاتی است که در این حمله وجود دارد. تنگناهایی که پیش از این مانع انجام عملیات سایبری در مقیاس گسترده میشد، اکنون تا حد زیادی کمتر شدهاند. اقتصاد حمله تغییر کرده است؛ حملات سریعتر و گستردهتر شدهاند و اجرای آنها برای مهاجمان مقرونبهصرفهتر است.

این تغییرات اثر دومینویی دارند. هنگامی که اجرای حمله آسانتر شود، بازیگران بیشتری وارد میدان میشوند. افزایش بازیگران یعنی عملیات بیشتر و عملیات بیشتر از یک سو باعث میشود فشار روی مدافعان سنگینتر میشود و از طرف دیگر مهاجمان فرصتهای بیشتری برای پیداکردن آسیبپذیریها و تکنیکهای جدید بهدست میآورند. این چرخه شتاب حملات را بیشتر میکند و باعث میشود که توان تهاجمی جلوتر از توان دفاعی حرکت میکند. به همین دلیل، ۱۲ تا ۱۸ ماه آینده یک دوره حیاتی برای سرمایهگذاری و استقرار دفاع سایبری است.

آنچه اکنون اهمیت دارد، سرعت است. اگرچه توان تهاجمی افزایش یافته است؛ اما ابزارهای دفاعی هم وجود دارند، فقط باید در مقیاس بزرگ و با سرعت پیادهسازی شوند. این حمله از یک سو نشان داد که علیرغم لایههای امنیتی در مدل هوش مصنوعی کلاود، امکان جیلبریک آن همچنان وجود دارد؛ اما از سوی دیگر ثابت کرد که نظارت و رصد موثر است و میتواند چنین عملیاتهایی را شناسایی و خنثی کند.

اینکه دوره آسیبپذیری ماهها طول بکشد یا سالها، به سه عامل بستگی دارد؛ نخست اینکه سازمانها با چه سرعتی روی هوش مصنوعی دفاعی سرمایهگذاری خواهند کرد، سیاستگذاران چقدر میتوانند در پذیرش فناوریهای دفاعی موثر باشند و در نهایت اینکه جامعه امنیت سایبری با چه کیفیتی اطلاعات و تجربیات خود را به اشتراک خواهد گذاشت.